日期:2025/04/05 08:31来源:未知 人气:52

尽管DeepSeek功能强大,但它需要联网才能使用,这给审计人员带来了诸多不便。同时,内部资料和数据也无法传输到网络或App版本的DeepSeek中,这无疑增加了审计工作的难度。

尽管有许多教程介绍如何通过ollama进行本地部署DeepSeek,但这些教程往往过于技术化,涉及命令行窗口和系统环境变量设置,这让许多非专业人士望而却步。

选择本地部署,使用三个工具软件(ollama + ollama master + Cherry Studio),只需简单三步,无需复杂代码和命令行操作,即可轻松打造一个离线本地版DeepSeek。这个版本不仅离线可用,确保了隐私保护,还无需API调用费,并可深度对接内部系统,满足审计人员的各种需求。

本教程考虑到了大多数审计人的办公环境,因此推荐使用Windows10及以上操作系统。此外,运行DeepSeek生成的Python代码需要另行安装Python运行环境。

对于配置需求,我们提供了不同级别的建议以满足不同需求。从基础的入门配置到高级配置,您可以根据实际情况选择适合您的方案。

通过ollama进行本地部署DeepSeek的过程非常简单。您只需按照以下三个步骤操作:首先安装Ollama,这是一款专为技术小白设计的本地大模型部署工具;其次,启动Ollama并加载DeepSeek模型;最后,通过简单操作即可开始使用DeepSeek进行审计工作。整个过程无需复杂代码和命令行操作,轻松上手。 1️⃣ 下载安装包

前往Ollama官方网站(https://ollama.com/),选择适合Windows系统的版本进行下载。

2️⃣ 轻松安装

2️⃣ 轻松安装

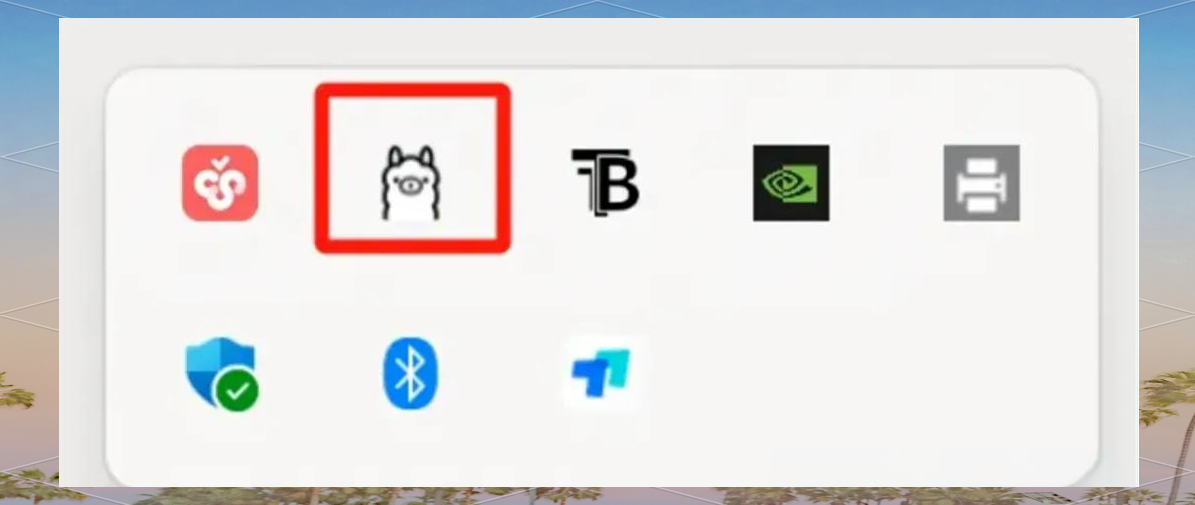

下载完成后,双击运行 OllamaSetup.exe 进行安装。安装完成后,系统右下角任务栏将出现 Ollama 的图标,表示安装成功。

在完成安装后,您需要下载与 Ollama 兼容的模型。这些模型通常是预训练的深度学习模型,能够为 Ollama 提供必要的计算和推理能力。请根据您的需求选择适当的模型进行下载。 1️⃣ 下载Ollama Master工具

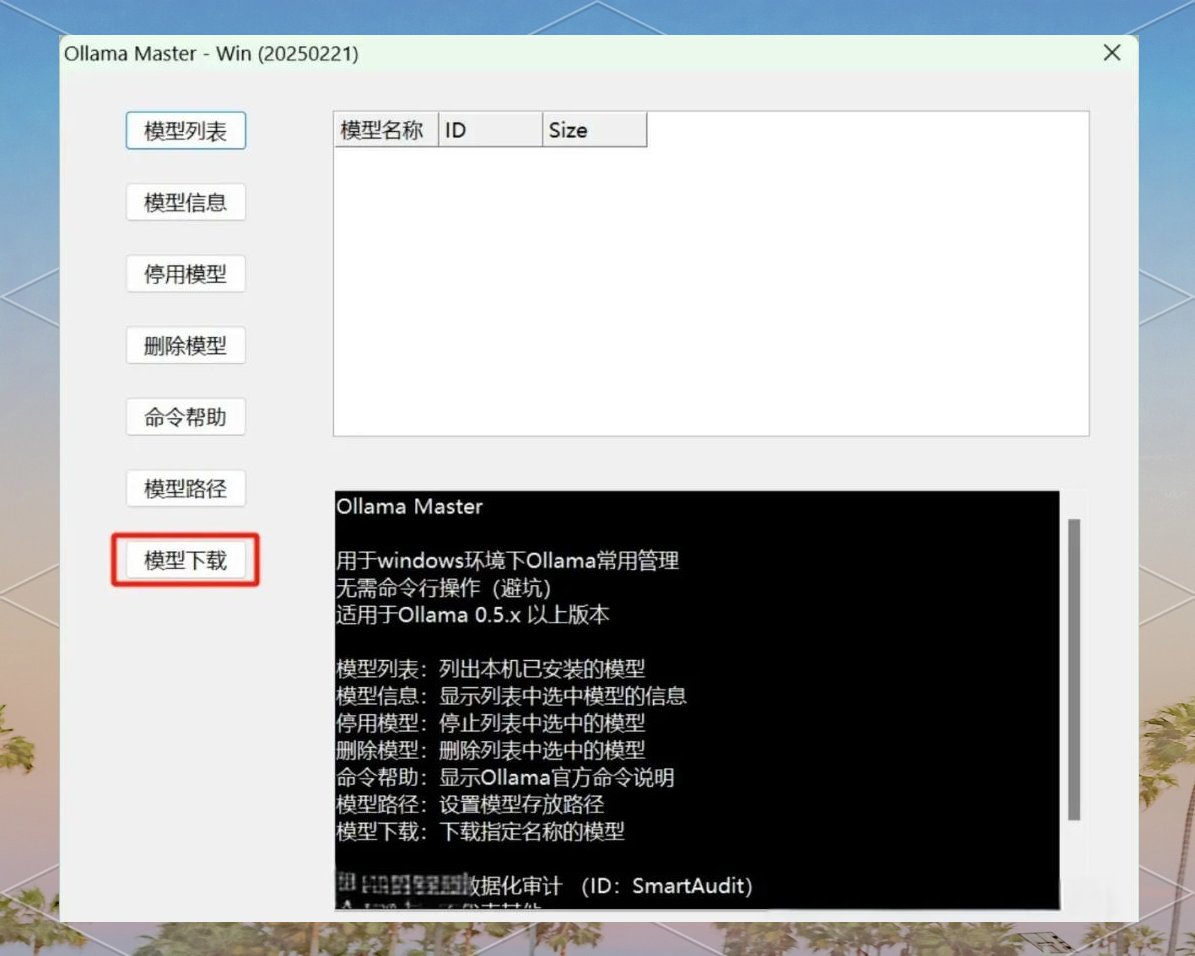

为了进一步提升Ollama的使用体验,我们开发了Ollama Master工具,它对Ollama的命令行进行了优化,使得用户可以通过鼠标进行操作,极大降低了使用门槛。此外,该工具还提供了详细的介绍和使用说明。

下载地址:https://pan.baidu.com/s/12YbwXbNVQEiCF0wlL7cMRw 提取码:n3e4

下载完成后,无需安装,只需解压OllamaMaster-Win20250221.zip文件即可开始使用。 2️⃣ 下载DeepSeek

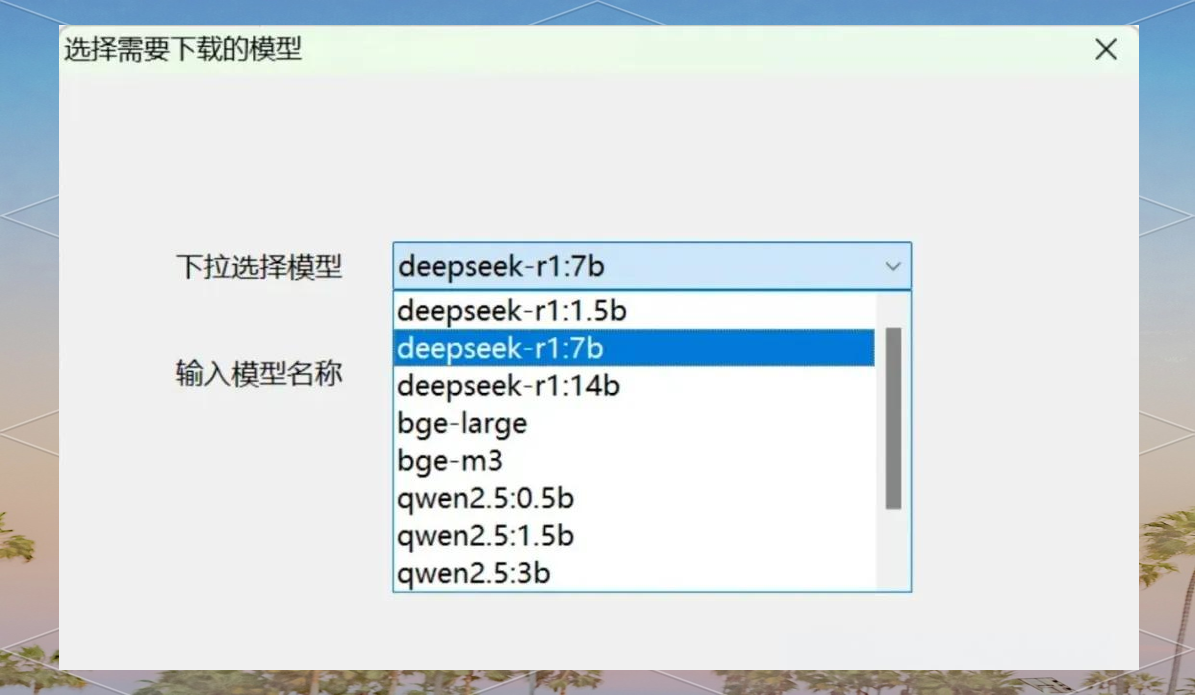

在Ollama Master工具中,您可以轻松下载所需的DeepSeek版本。只需打开工具,进入模型下载页面,然后选择您需要的deepseek-r1版本进行下载。

若您希望尝试使用DeepSeek而无需高性能显卡,可以选择下载1.5b版本。对于配备普通显卡的电脑,推荐选择7b版本。若显卡性能优越,则14b版本将能更好地发挥DeepSeek的性能。此外,若您计划使用CherryStudio的本地知识库功能,还需额外下载bge嵌入模型。

若您希望尝试使用DeepSeek而无需高性能显卡,可以选择下载1.5b版本。对于配备普通显卡的电脑,推荐选择7b版本。若显卡性能优越,则14b版本将能更好地发挥DeepSeek的性能。此外,若您计划使用CherryStudio的本地知识库功能,还需额外下载bge嵌入模型。

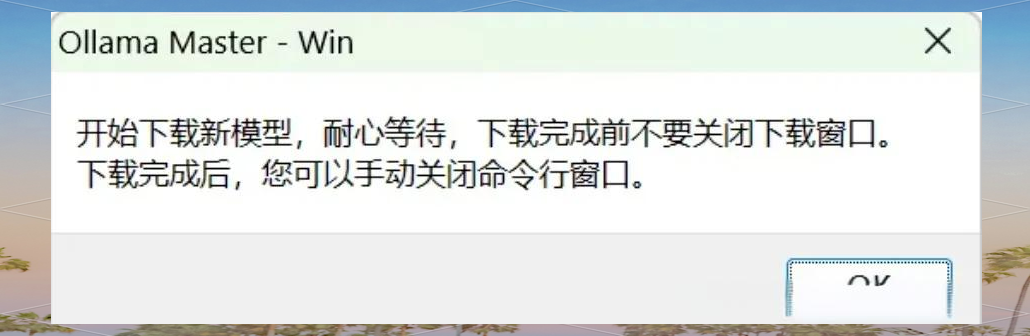

请留意OllamaMaster的指引。

请留意OllamaMaster的指引。

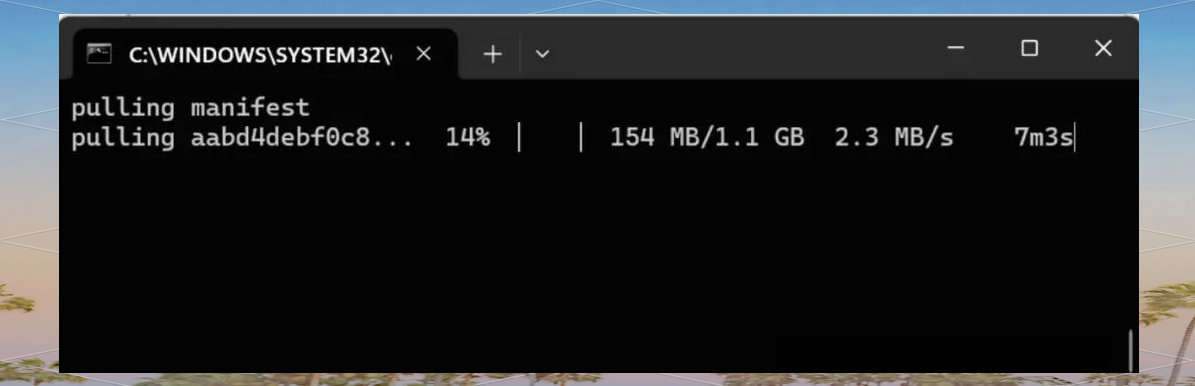

出现以下黑框表示正在下载,请勿关闭。

我当前下载的是最小的1.5b模型,其文件大小为1.1G。

出现以下黑框表示正在下载,请勿关闭。

我当前下载的是最小的1.5b模型,其文件大小为1.1G。

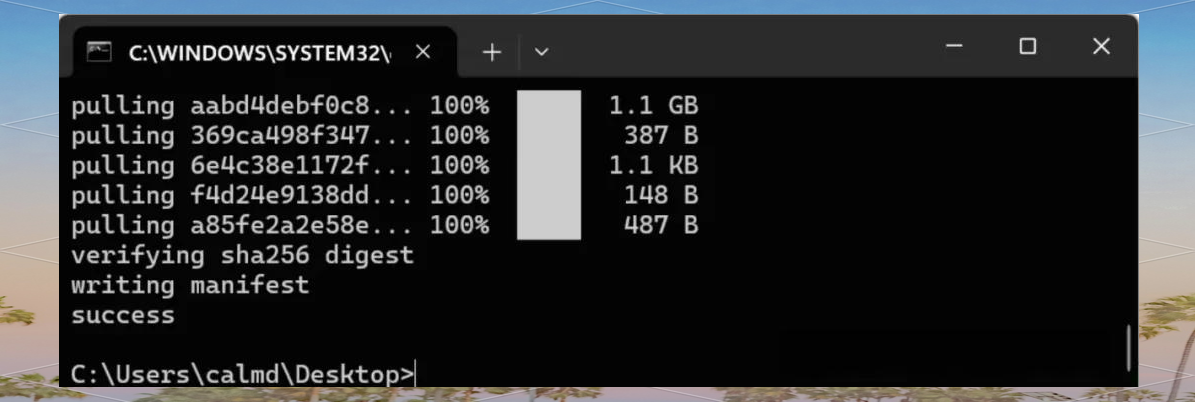

下载完成后,您可以关闭相关窗口。

下载完成后,您可以关闭相关窗口。

点击“模型列表”,若能见到您刚刚下载的模型,那便意味着下载工作已成功完成。至此,您已顺利完成了deepseek的本地部署。

3️⃣ 调整模型存储路径

点击“模型列表”,若能见到您刚刚下载的模型,那便意味着下载工作已成功完成。至此,您已顺利完成了deepseek的本地部署。

3️⃣ 调整模型存储路径

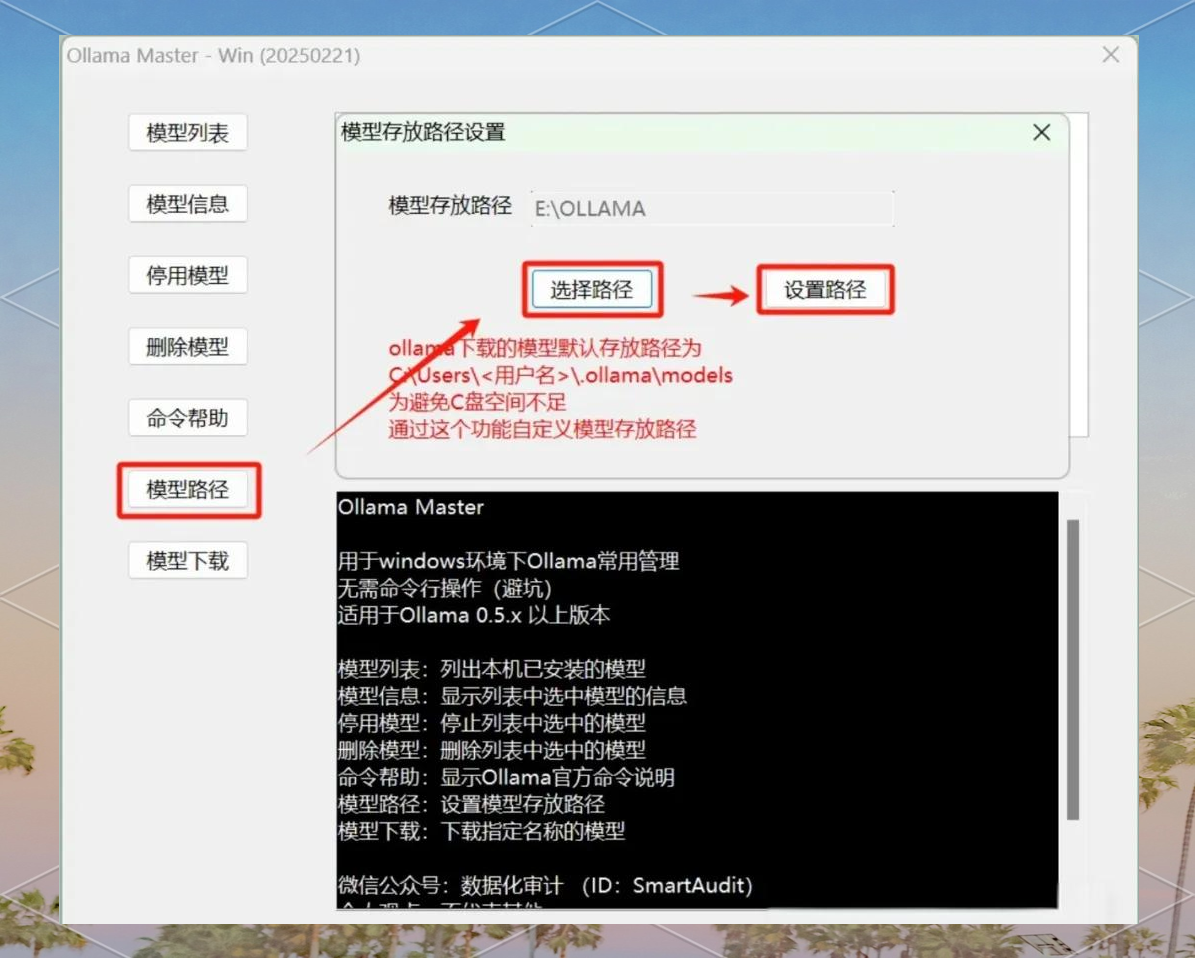

通常,模型会预设安装在C盘。但若C盘空间不足,您可借助Ollama Master工具来更改存储位置后再进行下载。(此步骤并非强制执行)

具体操作如下:进入“模型路径”设置,选择您希望存放模型的文件夹,并确认路径设置。请留意,修改完成后需重启电脑以使新路径生效。

步骤三:利用图形界面操作DeepSeek

在完成模型存储路径的调整后,您可以通过图形界面进一步操作DeepSeek。

1️⃣ 安装工具:Cherry Studio

步骤三:利用图形界面操作DeepSeek

在完成模型存储路径的调整后,您可以通过图形界面进一步操作DeepSeek。

1️⃣ 安装工具:Cherry Studio

Cherry Studio 是一款适用于Windows、macOS和Linux系统的跨平台桌面客户端,未来还将进一步拓展至移动端。它不仅集成了诸如OpenAI、Gemini、Anthropic等大型语言模型,还支持本地模型的运行。用户通过这款软件,可以轻松切换不同的AI模型,实现多模型对话、文档处理以及内容生成等多样化功能。想要了解更多或进行安装,请访问官方网站https://cherry-ai.com/并下载使用。

2️⃣ 配置模型

2️⃣ 配置模型

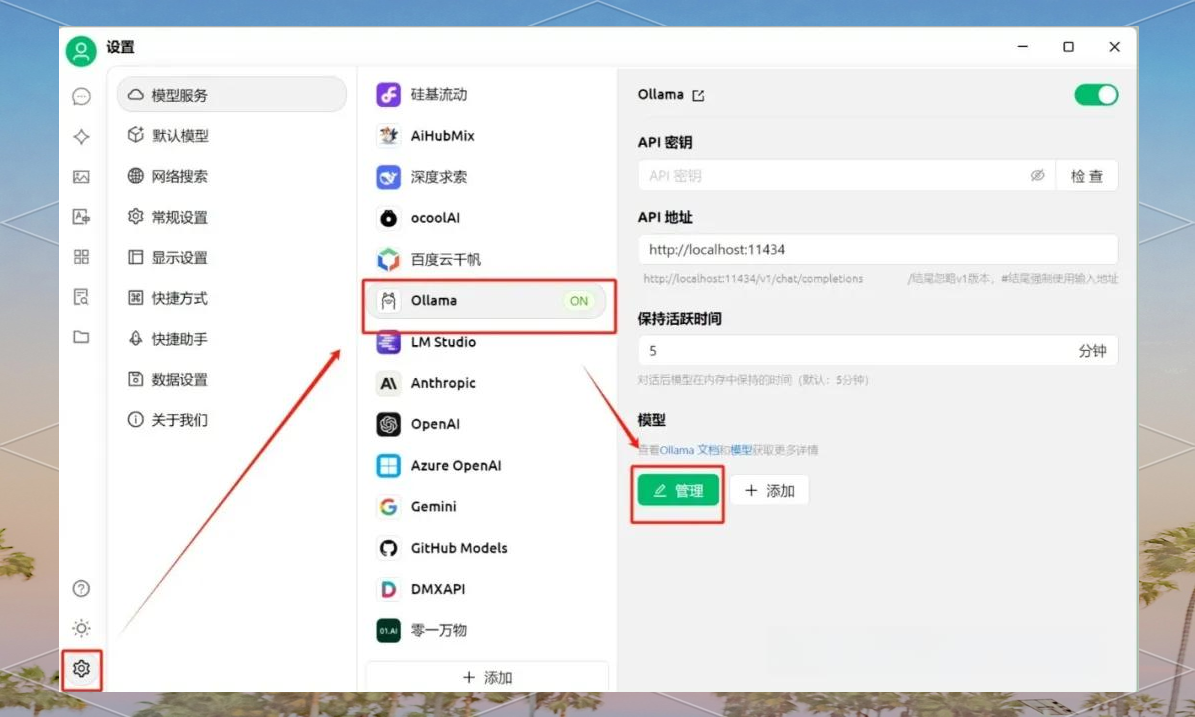

在Cherry Studio中,点击左下角齿轮图标“设置”,进入“模型服务”选项,选择Ollama进行管理。

在Cherry Studio的“模型服务”中,我们可以看到已经下载好的DeepSeek模型。要使用该模型,只需点击绿色加号进行添加。

在Cherry Studio的“模型服务”中,我们可以看到已经下载好的DeepSeek模型。要使用该模型,只需点击绿色加号进行添加。

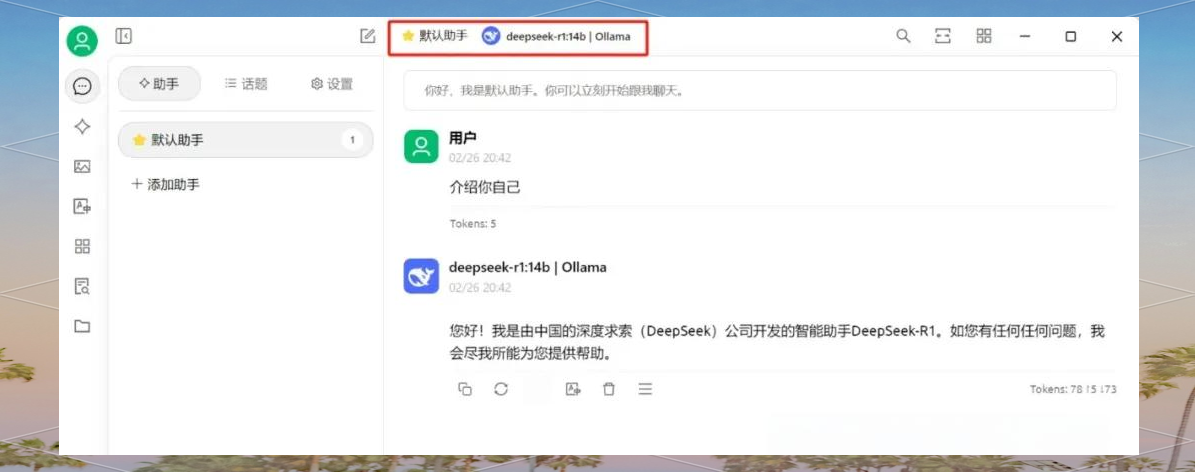

在“模型服务”的顶部,我们可以看到一个默认助手,通过它可以选择我们想要使用的模型。

在“模型服务”的顶部,我们可以看到一个默认助手,通过它可以选择我们想要使用的模型。

接下来,你可以尽情与DeepSeek进行交流互动!

此外,借助Cherry Studio的强大功能,你还可以构建属于自己的本地知识库。但在此过程中,可能会遇到诸多挑战,这也为后续探讨提供了丰富的素材。

接下来,你可以尽情与DeepSeek进行交流互动!

此外,借助Cherry Studio的强大功能,你还可以构建属于自己的本地知识库。但在此过程中,可能会遇到诸多挑战,这也为后续探讨提供了丰富的素材。

在提及Ollama的使用时,安全性问题显得尤为重要。尽管Ollama主要在本地处理数据,但用户仍需对本地设备的安全保持警惕。例如,确保电脑安全至关重要,定期更新系统补丁、杀毒软件和防火墙等安全措施是必不可少的。同时,由于Ollama尚存在部分未修补的漏洞,用户应采取额外安全措施,如使用代理或Web应用防火墙来保护暴露在互联网上的端点。综上所述,虽然Ollama设计为本地运行且不会主动泄露用户信息,但用户仍需高度重视并保障本地设备的安全。